Unreal Engine 4 - GDC 2018: Star Wars Raytracing-Techdemo; "Next-Gen-Darstellung" eines digitalen Menschen

Moderatoren: Moderatoren, Redakteure

-

Doc Angelo

- Beiträge: 5158

- Registriert: 09.10.2006 15:52

- User ist gesperrt.

- Persönliche Nachricht:

Re: Unreal Engine 4 - GDC 2018: Star Wars Raytracing-Techdemo; "Next-Gen-Darstellung" eines digitalen Menschen

Ich bin mir irgendwie nicht sicher, ob die Spielewelt diese Technologie wirklich braucht. Technisch gesehen ist es natürlich korrekter als Spiegelungen von einer Environment Map. Aber braucht man das wirklich? In dem StarWars-Video waren es nur sehr kurze Szenen, wo die neue Technik wirklich von Sinn gewesen wäre - also spürbar anderer Optik. Und in diesen Momenten hat wohl kaum jemand auf den Metall-Helm geguckt, um zu sehen wie die Reflektionen tatsächlich wandern, während der Helm sich durch den Flur bewegt.

Genau so bei Schatten: Ich kenne einige Spiele, bei denen wirft jeder Baum und jedes Blatt an diesem Baum einen absolut korrekten Schatten. Warum muss sowas 60 mal pro Sekunde berechnet werden? Warum kann das nicht als Schatten-Map vorberechnet werden? Selbst in Spielen wo die Sonne/das Licht in recht schneller Bewegung ist - würde man da wirklich den Unterschied rauserkennen - selbst wenn man bewusst drauf achten würde?

Insgesamt sehe ich keinen großen Sinn in mathematisch korrekter Beleuchtung. Es geht doch vielmehr um das Design und den Eindruck. Also ich wäre für mehr Design und weniger "kalte Mathematik".

Genau so bei Schatten: Ich kenne einige Spiele, bei denen wirft jeder Baum und jedes Blatt an diesem Baum einen absolut korrekten Schatten. Warum muss sowas 60 mal pro Sekunde berechnet werden? Warum kann das nicht als Schatten-Map vorberechnet werden? Selbst in Spielen wo die Sonne/das Licht in recht schneller Bewegung ist - würde man da wirklich den Unterschied rauserkennen - selbst wenn man bewusst drauf achten würde?

Insgesamt sehe ich keinen großen Sinn in mathematisch korrekter Beleuchtung. Es geht doch vielmehr um das Design und den Eindruck. Also ich wäre für mehr Design und weniger "kalte Mathematik".

Wenn man bis zum Hals in der Scheiße steckt, sollte man nicht den Kopf hängen lassen.

-

johndoe1741084

- Beiträge: 2626

- Registriert: 21.09.2014 13:04

- Persönliche Nachricht:

Re: Unreal Engine 4 - GDC 2018: Star Wars Raytracing-Techdemo; "Next-Gen-Darstellung" eines digitalen Menschen

Ich gestehe, daß ich nun selber nicht mehr weiß, was ich sagen wollte

Spaß

Vllcht sollte ich ersma definieren was ich unter IndieFilm so verstehe...

Kennst du "Cargo"?

Dem Film hätten ein paar bessere Effekte gut getan (auch um die eine oder andere schauspielerische Leistung auszugleichen

Und die hätten durch zugänglichere/bessere Tools durchaus erreicht werden können, auch weil die Kostenfrage für eine(n) Filmförderfond/FilmHochSchule durchaus wichtig ist.

Beispiel FilmBearbeitung mit AfterEffects:

Vor paar Jahren war die PostProduktion noch etwas sehr handwerklich technisches, studierenswertes

Heute kann sich jeder für 60€/Monat die CC holen, ne Woche "Lehrvideos" reinziehn und kommt schon zu sehr achtbaren Ergebnissen.

Macht die Filme nicht handwerklich besser, dafür aber optisch sehr viel "filmischer" als das noch zuvor möglich war.

Kann man halt ziemlich viel ausgleichen, eben durch jene Tools, die es vorher nicht gab.

e: Im Prinzip wollte ich ohnehin nur darauf hinaus, daß diese Technologie eher interessant für die Filmbranche ist, da dort auch die Rechner stehen, die damit was anfangen können.

- Sir Richfield

- Beiträge: 17249

- Registriert: 24.09.2007 10:02

- Persönliche Nachricht:

-

johndoe1741084

- Beiträge: 2626

- Registriert: 21.09.2014 13:04

- Persönliche Nachricht:

Re: Unreal Engine 4 - GDC 2018: Star Wars Raytracing-Techdemo; "Next-Gen-Darstellung" eines digitalen Menschen

Nope ... gleich mal gebookmarked...Merci.

interessante Sachn bei...

PS: Das is ja vom N.Blomkamp hat mir wiki erzählt

- Sir Richfield

- Beiträge: 17249

- Registriert: 24.09.2007 10:02

- Persönliche Nachricht:

Re: Unreal Engine 4 - GDC 2018: Star Wars Raytracing-Techdemo; "Next-Gen-Darstellung" eines digitalen Menschen

Jupp.

Musste im Verlauf der Diskussion daran denken, weil die in letzter Zeit ein paar Konzeptdinger gemacht haben, die angeblich in Echtzeit in der Unity Engine laufen.

Re: Unreal Engine 4 - GDC 2018: Star Wars Raytracing-Techdemo; "Next-Gen-Darstellung" eines digitalen Menschen

Ärmere Leute werden wahrscheinlich nie in den Genuss kommen fotorealistische Gesichter zu sehen.

Re: Unreal Engine 4 - GDC 2018: Star Wars Raytracing-Techdemo; "Next-Gen-Darstellung" eines digitalen Menschen

Schatten vorzuberechnen ist eigentlich Standard (+Selbstverdeckung (Ambient Occluision)). Schatten realtime zu erzeugen, wird nur bei beweglichen Objekten oder bewegliche Lichtquellen gemacht und das möglichst selten. Wenn man Schatten vorberechnet hat man 0 Rechenzeitanforderungen während der Anwendung.Doc Angelo hat geschrieben: ↑22.03.2018 14:34 Ich bin mir irgendwie nicht sicher, ob die Spielewelt diese Technologie wirklich braucht. Technisch gesehen ist es natürlich korrekter als Spiegelungen von einer Environment Map. Aber braucht man das wirklich? In dem StarWars-Video waren es nur sehr kurze Szenen, wo die neue Technik wirklich von Sinn gewesen wäre - also spürbar anderer Optik. Und in diesen Momenten hat wohl kaum jemand auf den Metall-Helm geguckt, um zu sehen wie die Reflektionen tatsächlich wandern, während der Helm sich durch den Flur bewegt.

Genau so bei Schatten: Ich kenne einige Spiele, bei denen wirft jeder Baum und jedes Blatt an diesem Baum einen absolut korrekten Schatten. Warum muss sowas 60 mal pro Sekunde berechnet werden? Warum kann das nicht als Schatten-Map vorberechnet werden? Selbst in Spielen wo die Sonne/das Licht in recht schneller Bewegung ist - würde man da wirklich den Unterschied rauserkennen - selbst wenn man bewusst drauf achten würde?

Insgesamt sehe ich keinen großen Sinn in mathematisch korrekter Beleuchtung. Es geht doch vielmehr um das Design und den Eindruck. Also ich wäre für mehr Design und weniger "kalte Mathematik".

Raytracing ist aber nicht da um primäre Schatten oder Lichter zu berechnen, sondern um die globale Beleuchtung zu simulieren. Das heißt, Licht das irgendwo abprallt und weiter wo anders beleuchtet und dabei abfärbt. Außerdem ist es ganz nett für Transparenzen und Brechungen. Die Environment Map die du ansprichst, berechnet das Umgebunglicht um sich herum vor. Sprich bewegliche Objekte und Lichter fallen schon mal komplett raus. Des Weiteren kann es nicht Licht simulieren, dass direkt durch Wände verdeckt wird, aber indirekt durch andere Wege ankommt. In erste Linie wird das für Reflexionen benutzt und weniger für globales Licht.

Eine Alternative zu Raytracer in der Unreal Engine ist Lightmass Global Illumination. Die rendert den Kram auch als Lightmap vor und übt keine Rechenzeit aus. Aber das sind alles Annäherungen zu Raytracer & Radiosity und werden nie so gut funktionieren.

Ob Raytracer und Radiosity sinnvoll ist, liegt an den Wünschen. Animationsfilme, welche die absolut höchste grafische Bedrüfnisse erfüllen möchten, kannst du ohne diese Technologien nicht realisieren. Aber die Spiele werden durch Grafik auch nicht besser, wenn man das gleiche anspruchslose Lootbox-Sammelkram-Grind-Markierer-hier-und-da-Zero-Brain-needed Gameplay mit einer KI wie vor 10 Jahren hat und 0 künstlerischem Anspruch sondern Massenanpassung.

Aktuell überzeugt mMn nach auch eher der Artstyle / die Kreativität als die Grafik. Das neue GoW ist mir visuell überhaupt nicht aufgefallen, während Cuphead bis heute in meinem Kopf blieb.

Super Mario 64 | Mario Party 1 | Die Sims | Warcraft III | Jet Set Radio Future | Halo 2 | Dantes Inferno | Skate 2 | Heavy Rain | Harveys Neue Augen

Akutelle Gen: The Evil Within, Detroit, Life is Strange, Polybius, XCOM 2

Wanted: Death Stranding, Cyberpunk 2077, Scorn

Looking For: Super Mario 64 Remake, JSRF Port / Nachfolger

Akutelle Gen: The Evil Within, Detroit, Life is Strange, Polybius, XCOM 2

Wanted: Death Stranding, Cyberpunk 2077, Scorn

Looking For: Super Mario 64 Remake, JSRF Port / Nachfolger

-

Doc Angelo

- Beiträge: 5158

- Registriert: 09.10.2006 15:52

- User ist gesperrt.

- Persönliche Nachricht:

Re: Unreal Engine 4 - GDC 2018: Star Wars Raytracing-Techdemo; "Next-Gen-Darstellung" eines digitalen Menschen

Darunter würde alle Games fallen, die einen dynamischen Tag/Nacht-Ablauf haben. Das ist ja immer noch recht beliebt. Ein Fall der mir in Erinnerung blieb war "Aporia: Beyond the Valley". Das "Cry-Engine-Indie-Game des Jahres 2017". Da gab es so einige Schattenspiele, die zwar irgendwie nett aussahen, aber doch eher auf der künstlichen Seite wirkten - immerhin kann man es mit der Auflösung der Shadow-Map nicht übertreiben - und berechnete weiche Schatten kann nicht jede Hardware wuppen. Es war zwar mathematisch korrekter Schatten. Aber was nutzt das, wenn das normale menschliche Auge sowieso keinen Unterschied erkennen könnte?Xyt4n hat geschrieben: ↑22.03.2018 17:35 Schatten vorzuberechnen ist eigentlich Standard (+Selbstverdeckung (Ambient Occluision)). Schatten realtime zu erzeugen, wird nur bei beweglichen Objekten oder bewegliche Lichtquellen gemacht und das möglichst selten. Wenn man Schatten vorberechnet hat man 0 Rechenzeitanforderungen während der Anwendung.

Genau. Meiner Meinung nach reicht das völlig aus. Nochmal das Beispiel des Helmes aus dem Video: Wer würde schon genau auf den Helm gucken und feststellen: "Hey! Hätte sich die Spiegelung des Lichtes nicht nach unten verziehen müssen, als der Helmträger begann, den Lift zu verlassen?"Xyt4n hat geschrieben: ↑22.03.2018 17:35Die Environment Map die du ansprichst, berechnet das Umgebunglicht um sich herum vor. Sprich bewegliche Objekte und Lichter fallen schon mal komplett raus. Des Weiteren kann es nicht Licht simulieren, dass direkt durch Wände verdeckt wird, aber indirekt durch andere Wege ankommt. In erste Linie wird das für Reflexionen benutzt und weniger für globales Licht.

Vielleicht ist das auch einfach ne Folge von der Tatsache, das 3D-Engines von "Mathe-Nerds" geschrieben werden, und nicht von Designern.

Wenn man bis zum Hals in der Scheiße steckt, sollte man nicht den Kopf hängen lassen.

-

Doc Angelo

- Beiträge: 5158

- Registriert: 09.10.2006 15:52

- User ist gesperrt.

- Persönliche Nachricht:

Re: Unreal Engine 4 - GDC 2018: Star Wars Raytracing-Techdemo; "Next-Gen-Darstellung" eines digitalen Menschen

Ich hab gerade das Techdemo-Video von Metro gesehen. Da sieht man eigentlich ganz gut, was ich meine. Die ganze Szenerie ist im Grunde ein Stillleben, von Wasser und Bäumen abgesehen. Die flimmernden Schatten des Blätterwerkes fallen in das zerfallene Haus. Durch die geringe Shadow-Map flimmert es leider wortwörtlich. Das flimmert rührt daher, das die resultierende Shadow-Map nur 1 Bit Farbtiefe hat - entweder vollkommen Schatten oder gar kein Schatten. Hier wird der Schatten live berechnet, obwohl man praktisch außerstande ist, überhaupt nachzuvollziehen, ob der Schatten nun korrekt ist oder nicht. Man könnte es selbst dann nicht, wenn die Auflösung der Shadow-Map um ein vielfaches höher wäre. Die Auflösung ist niedrig, weil die Berechnung für die niedrige Auflösung schon sehr aufwändig ist. Somit wird die Sinnhaftigkeit dieser Technik von ihr selbst noch weiter reduziert.Xyt4n hat geschrieben: ↑22.03.2018 17:35 Schatten vorzuberechnen ist eigentlich Standard (+Selbstverdeckung (Ambient Occluision)). Schatten realtime zu erzeugen, wird nur bei beweglichen Objekten oder bewegliche Lichtquellen gemacht und das möglichst selten. Wenn man Schatten vorberechnet hat man 0 Rechenzeitanforderungen während der Anwendung.

http://www.4players.de/4players.php/spi ... xodus.htmlWe have utilized true raytracing to render both Ambient Occlusion and Indirect Lighting in full realtime, in a practical in-game scenario.

Wenn man bis zum Hals in der Scheiße steckt, sollte man nicht den Kopf hängen lassen.

- Skippofiler22

- Beiträge: 7079

- Registriert: 21.07.2008 17:09

- User ist gesperrt.

- Persönliche Nachricht:

Re: Unreal Engine 4 - GDC 2018: Star Wars Raytracing-Techdemo; "Next-Gen-Darstellung" eines digitalen Menschen

Die Grafiken sind an sich sehr schön. Aber richtig gut hat mir es gefallen, wie ein "alter Hase des Schauspielgschäfts" diesen einen Außerirdischen "zum Leben erweckt" hat. Ich habe lange nicht mehr so viel Gänsehaut gehabt.

Es ist nicht zu verantworten, sagte die Vernunft.

Es ist durchaus machbar, sagte der Ehrgeiz.

Es ist nicht alles richtig, sagte der Verstand

Tue es, sagte der Leichtsinn.

Du bist was du bist, sagte das Selbstbewusstsein.

Es ist einfach schön, sagte die Liebe.

Es ist das Gefühl in eine andere Welt einzutauchen, sagte der Gamer.

Es ist durchaus machbar, sagte der Ehrgeiz.

Es ist nicht alles richtig, sagte der Verstand

Tue es, sagte der Leichtsinn.

Du bist was du bist, sagte das Selbstbewusstsein.

Es ist einfach schön, sagte die Liebe.

Es ist das Gefühl in eine andere Welt einzutauchen, sagte der Gamer.

Re: Unreal Engine 4 - GDC 2018: Star Wars Raytracing-Techdemo; "Next-Gen-Darstellung" eines digitalen Menschen

Also wie Tag/Nacht Wechsel realisiert werden, kann ich dir nicht sagen, da ich mich nie damit auseinandergesetzt und es selbst nicht programmiert habe. Ich könnte mir vorstellen, dass sie ca 24 Lightmaps vorrendern und sie je nach Tageszeit laden. Da ist halt die Frage ob große Texturen geladen werden können, ohne das es auffällt, aber auf jeden Fall wäre das eine extrem sparsame Maßnahme gegenüber dynamische Schattenberechnung.

Die andere Frage ob man es merkt. Ich würde sagen ja, aber unterbewusst. Ein Mensch der sich nicht mit Lichtberechnung auskennt, wird jetzt nicht feststellen woran es der Grafik fehlt und inwiefern es abfälscht. Ich habe als Kind jahrelang Mario64 gespielt und kam nie auf die Idee, dass die Schattenberechnung des Characters total irreal ist und nur helfen soll die Lage des Characters im 3D Raum einschätzen zu können (Ich weiß grad nicht wie die Methode heißt, aber sie berechnet einfach nur ein Schattenkreis direkt unter dem Modell). Dagegen heute mit mehr Erfahrung fällt es schon auf.

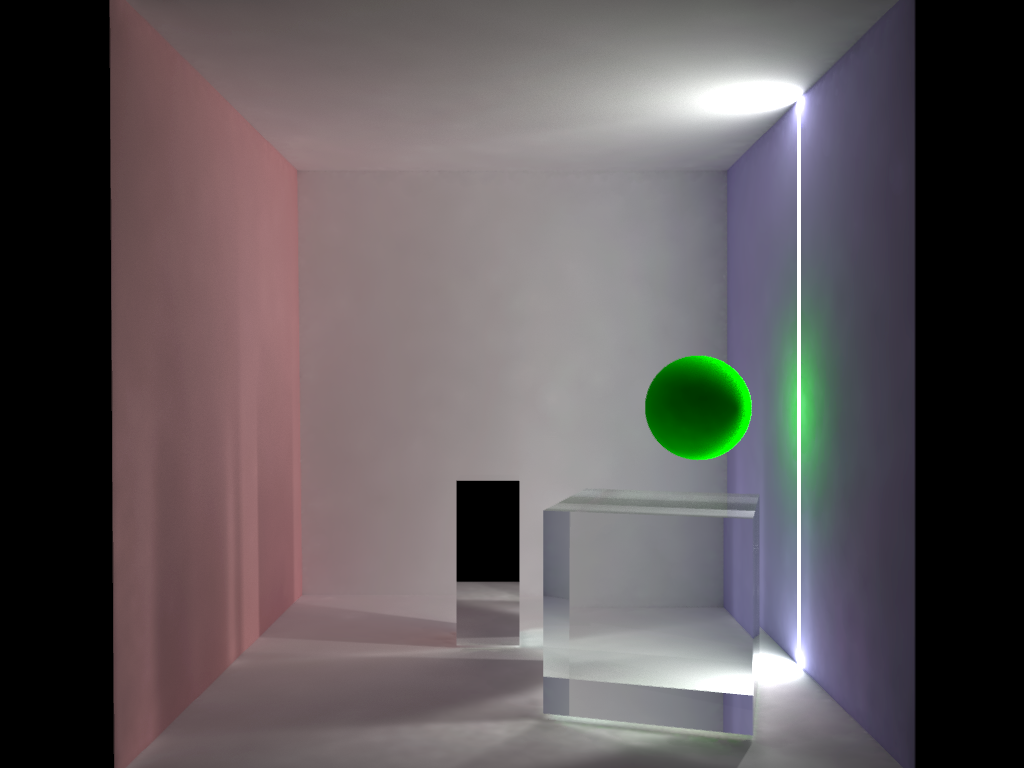

Lichtberechnung zu beurteilen ist keine einfache Sache. Deswegen werden häufig die Lichtberechnung in der Cornell Box Scene dargestellt, damit man einfacher differenzieren kann.

Aber das Unterbewusstsein kann die Grafik schon gut einschätzen. Es wirkt sich mehr auf das Gefühl aus, als auf den Intellekt. Es fällt jetzt nicht auf, dass die Lichtberechnung eine Abfärbung zum Beispiel besitzt, sondern es wirkt real. Hattest du nicht ein anderes Gefühl bei der Star Wars Demo, als bei bspw. Uncharted? Wirkte es nicht realer und so als ob man es anfassen könnte?

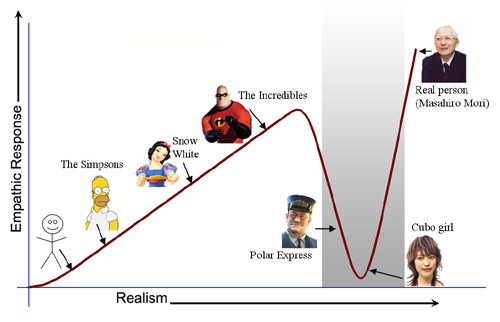

Natürlich kann es dabei zu Limitationen kommen, die du angesprochen hast. Ich würde auch lieber 4k und 60fps vorziehen, als einfaches flimmer Raytracing bei 720p und 30fps. Aber in Zukunft wird man immer mehr Ressourcen haben und die Rechenpower wird man damit füttern können um ein wenig besseres Bild zu bekommen. Aber schon jetzt hat die Spielebranche Probleme mit dem Uncanny Valley. Weswegen Spiele vlt in Zukunft weniger häufig einen realistischen Artstyle besitzen und viel mehr den Weg der Animationsbranche gehen und es abstrahieren.

Btw. "gute" Grafik kann manchmal auch nach hinten losgehen wie zum Beispiel bei Lens Flares. Lens Flares sehen in Spielen so ähnlich wie im rechten Beispiel aus. Das sind aber Lens Flares die durch das Objektiv der Kamera entstehen. Links ist ein realistisches Lens Flare gerendert, dass so aussieht, wenn man mit den Augen in die Lichtquelle schaut und nicht mit einem Objektiv. Im Normalfall identifiziert man sich in Spielen mit dem Character und nicht mit einer Kamera. Leider macht das die Spieleindustrie die ganze Zeit falsch, es ist echt amüsant

Wissenschaftliche Quelle

Dies versteht auch das Unterbewusstsein. Wenn du ein VR Spiel spielst werden dir solche falschen Lens Flares störend auffallen, außer du betrachtest in dem Spiel das Bild einer Kamera das eingeblendet wird. Deswegen werden in der Regel Lens Flares in VR Spielen vermieden. Dagegen würden realistische Lens Flares wahrscheinlich nicht negativ auffallen, aber ich kenne kein Beispiel

Super Mario 64 | Mario Party 1 | Die Sims | Warcraft III | Jet Set Radio Future | Halo 2 | Dantes Inferno | Skate 2 | Heavy Rain | Harveys Neue Augen

Akutelle Gen: The Evil Within, Detroit, Life is Strange, Polybius, XCOM 2

Wanted: Death Stranding, Cyberpunk 2077, Scorn

Looking For: Super Mario 64 Remake, JSRF Port / Nachfolger

Akutelle Gen: The Evil Within, Detroit, Life is Strange, Polybius, XCOM 2

Wanted: Death Stranding, Cyberpunk 2077, Scorn

Looking For: Super Mario 64 Remake, JSRF Port / Nachfolger

- Sir Richfield

- Beiträge: 17249

- Registriert: 24.09.2007 10:02

- Persönliche Nachricht:

Re: Unreal Engine 4 - GDC 2018: Star Wars Raytracing-Techdemo; "Next-Gen-Darstellung" eines digitalen Menschen

Noch geiler ist ja, dass viele versuchen, ihre Aufnahmen nicht mit Lensflares zu verseuchen und die Spieleleute ballern den überall rein.Xyt4n hat geschrieben: ↑23.03.2018 13:56Links ist ein realistisches Lens Flare gerendert, dass so aussieht, wenn man mit den Augen in die Lichtquelle schaut und nicht mit einem Objektiv. Im Normalfall identifiziert man sich in Spielen mit dem Character und nicht mit einer Kamera. Leider macht das die Spieleindustrie die ganze Zeit falsch, es ist echt amüsant

Wobei Lensflare eher ein Photoshop-Problem war.

Was bei den Spielemenschen so richtig gut als Effekt ankam und daher bis zum Erbrechen in alles geballlert wurde: BLOOM.

Google-BIldsuche nach "Bloom Syndicate", da haben die es echt üebrtrieben. Da wirst du von Stahltüren im dunklen Keller geblendet.

- SpookyNooky

- Beiträge: 2260

- Registriert: 19.10.2007 14:52

- Persönliche Nachricht:

Re: Unreal Engine 4 - GDC 2018: Star Wars Raytracing-Techdemo; "Next-Gen-Darstellung" eines digitalen Menschen

Ich glaube, das ist Absicht. Ich habe mich schon oft das gleiche gefragt, aber es gibt noch mehr Hinweise darauf, die eigentlich die Immersion stören sollten, weil sie so eine Art Durchbrechen der vierten Wand sind. Beispiele sind:

- Matsch auf der Monitorscheibe, wenn man durch Schlamm läuft

- Splittern des Glases auf dem Monitor, z.B. bei erlittenem Schaden

- Durchschimmern von Unebenheiten auf der Glasoberfläche direkt vor dem Gesicht, wenn man in helles Licht schaut (zu sehen hier direkt bei diesem Timecode unten rechts im Video https://youtu.be/L4A5mCXVYTk?t=12s )

- Die Art der Lens Flares

Das alles sagt mir, dass die Designer ähnlich wie im Film versuchen, das Gefühl zu vermitteln, dass zwischen Gesehenem und Erlebten eine Scheibe dazwischen ist. Man steuert grafisch gesehen wirklich eher eine Kamera, deren Linse verdrecken kann. Man blinzelt ja auch nie in Ego-Perspektiven.

Re: Unreal Engine 4 - GDC 2018: Star Wars Raytracing-Techdemo; "Next-Gen-Darstellung" eines digitalen Menschen

Doch, natürlich. Einfach mal aus dem Fenster schauen

Das ist alles richtig, aber auch irrelevant. Es ging ja hierbei nur darum zu zeigen, was alles möglich ist. Und das ist wirklich - wirklich ziemlich beeindruckend, wie ich finde.Rixas hat geschrieben: ↑22.03.2018 08:10 Betonung liegt dabei auf Zukunft, das Ding lief auf ner 50000$ Maschine, laut Arsetechnica sogar auf ner 150k Maschine von Nvidia. Egal was stimmt so schön die ganzen Demos auch sind, wird noch eine weile dauern bis wir davon wirklich alles in Spielen sehen werden. Eher so Next-Next Gen Stoff.

Ähnlich dem Zeug, was auf der ein oder anderen Automobilmesse zu sehen ist: ziemlich cool, aber für 3 Menschen auf der Welt.

-

Doc Angelo

- Beiträge: 5158

- Registriert: 09.10.2006 15:52

- User ist gesperrt.

- Persönliche Nachricht:

Re: Unreal Engine 4 - GDC 2018: Star Wars Raytracing-Techdemo; "Next-Gen-Darstellung" eines digitalen Menschen

Das ist ja irgendwie das Ding: Es gibt auf Automobil-Messen immer wieder Dinge zu sehen, die sind dermaßen praxis-untauglich, das sie niemals auf der Straße landen. Sieht es krass aus wenn man es ins Rampenlicht stellt? Ja. Braucht mans wirklich? Fuck no!

Wenn man bis zum Hals in der Scheiße steckt, sollte man nicht den Kopf hängen lassen.