AMD FidelityFX Super Resolution (FSR): Die Upscaling-Methode ist in den ersten Spielen verfügbar

Moderatoren: Moderatoren, Redakteure

Re: AMD FidelityFX Super Resolution (FSR): Die Upscaling-Methode ist in den ersten Spielen verfügbar

In Teilbereichen kann DLSS sogar besser sein weil es die Infos wie schon oft gesagt aus 16k Master lernt. Bestätigt auch Raff von PCGH öfters im Forum. Aussage war auch dass Bereiche besser sind Andere dafür etwas unschärfer. Aber DLSS nicht einfach was hinzudichtet was nicht im hochauflösenden Master da war. Bis auf vereinzelte Ghosting Artefakte. Nutzt nur Infos die man auch erhalten würde wenn man 8k-16k Downsampeln auf 4k macht.

Problem war bisher nur LOD bei älteren DLSS Implementierungen auf Render- aber nicht Zielauflösung eingestellt war. Wurde durch neue Richtlinien behoben.

Alles hat Vor- und Nachteile. Bild muss einem gefallen zurm gewählten Performanceziel.

Problem war bisher nur LOD bei älteren DLSS Implementierungen auf Render- aber nicht Zielauflösung eingestellt war. Wurde durch neue Richtlinien behoben.

Alles hat Vor- und Nachteile. Bild muss einem gefallen zurm gewählten Performanceziel.

-PC

-Playstation 5

-Nintendo Switch

-Xbox Series X

-Playstation 5

-Nintendo Switch

-Xbox Series X

Re: AMD FidelityFX Super Resolution (FSR): Die Upscaling-Methode ist in den ersten Spielen verfügbar

Ich finde auch, dass es etwas von der Spieleengine abhängt...warum auch immer...

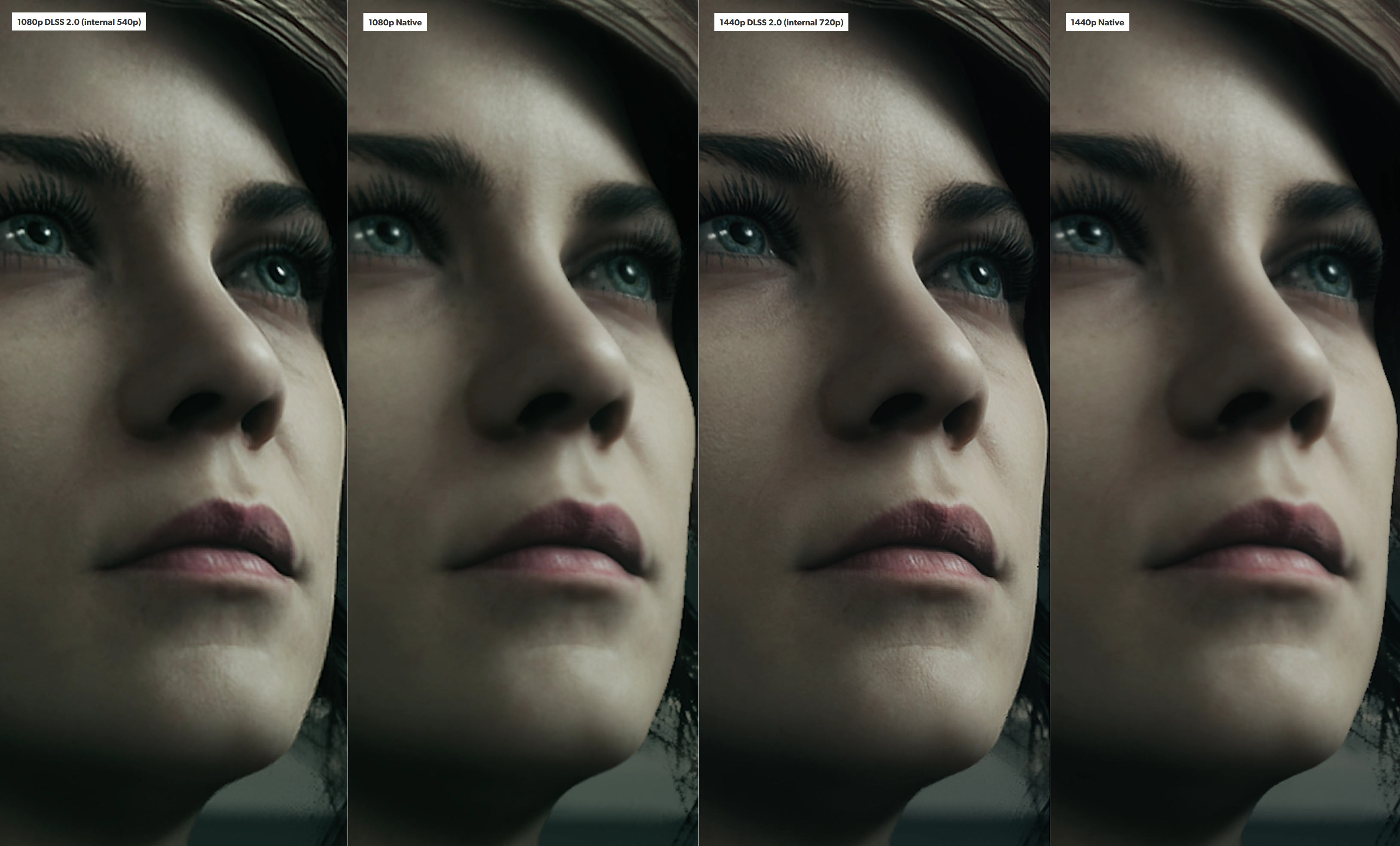

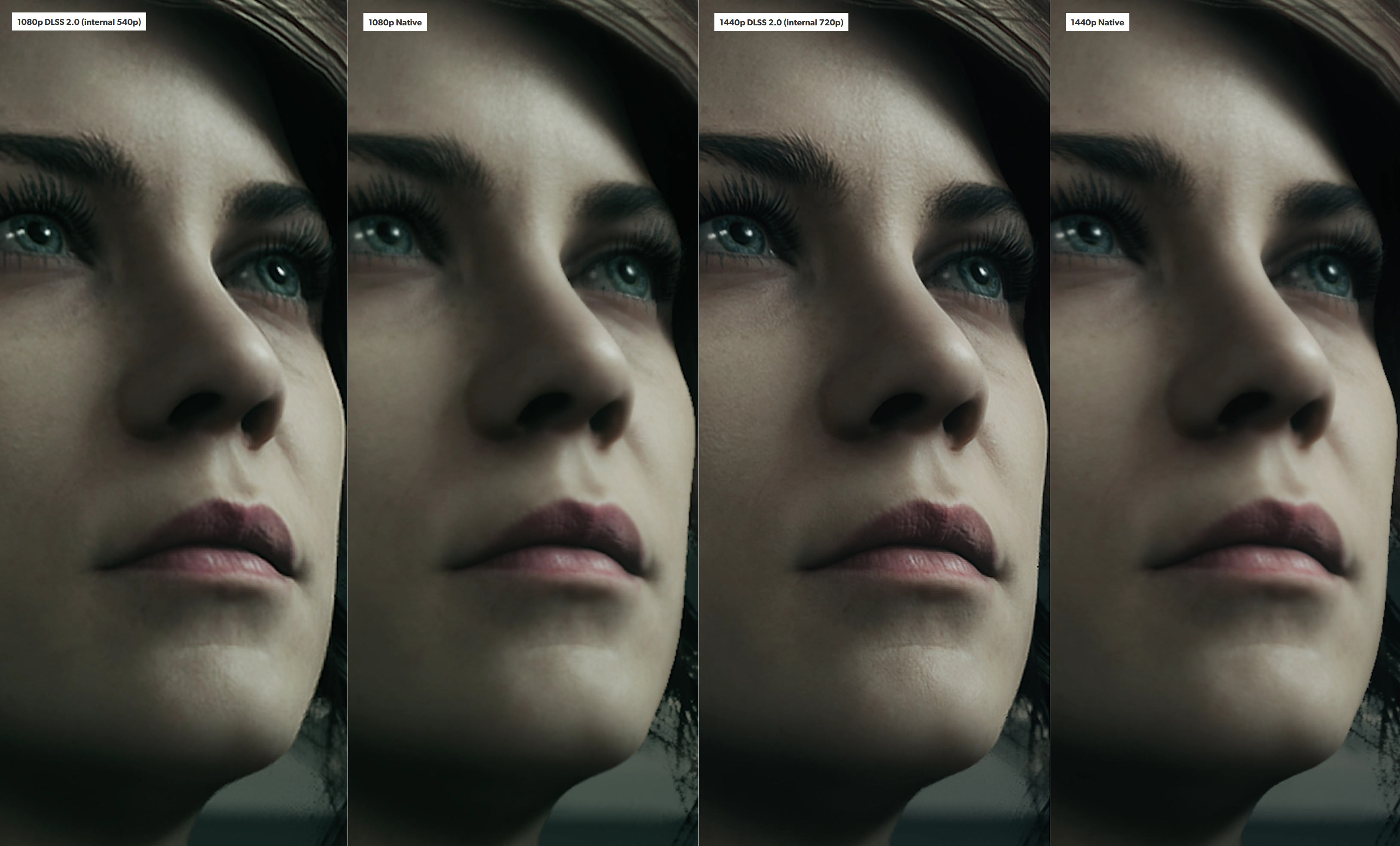

Control und wie im Bild Death Stranding sehen einfach unglaublich gut aus mit DLSS 2.0. Lediglich dieser leicht helle Rand, vornehmlich an Gesichtern, ist etwas störend, nehm ich aber kaum noch wahr.

Cyberpunk hingegen leidet selbst auf der Quality-Stufe unter Krieseln, vorallem bei den Straßen, was ich aus den beiden anderen Spielen halt gar nicht kenne...

Wie schon gesagt, bin ich auf die Implementierung bei RDR 2 gespannt.

Hier auch nochmal Control:

Da sieht man schon nochmal eine Verbesserung im vergleich zur nativen Auflösung.

Aber genug davon, hier geht´s immerhin um FSR und nicht DLSS.

Control und wie im Bild Death Stranding sehen einfach unglaublich gut aus mit DLSS 2.0. Lediglich dieser leicht helle Rand, vornehmlich an Gesichtern, ist etwas störend, nehm ich aber kaum noch wahr.

Cyberpunk hingegen leidet selbst auf der Quality-Stufe unter Krieseln, vorallem bei den Straßen, was ich aus den beiden anderen Spielen halt gar nicht kenne...

Wie schon gesagt, bin ich auf die Implementierung bei RDR 2 gespannt.

Hier auch nochmal Control:

Da sieht man schon nochmal eine Verbesserung im vergleich zur nativen Auflösung.

Aber genug davon, hier geht´s immerhin um FSR und nicht DLSS.

-

OchsvormBerg

- Beiträge: 1379

- Registriert: 12.03.2008 20:17

- Persönliche Nachricht:

Re: AMD FidelityFX Super Resolution (FSR): Die Upscaling-Methode ist in den ersten Spielen verfügbar

DLSS 2.X ist in der Qualitätseinstellung in den meisten Fällen auch besser als nativ, zumindest wenn die native Auflösung WQHD oder höher ist. Das sieht übrigens nicht nur DF so, sondern auch die meisten anderen ernst zu nehmenden Seiten, die DLSS 2.0 getestet haben. Mal abgesehen davon, dass DLSS ja auch noch einen sehr guten Anti-Aliasing Effekt von Haus aus mitbringt, was zusätzlich Leistung spart, denn ein natives Bild ist ja erstmal ungeglättet.Temeter hat geschrieben: ↑24.06.2021 12:15 Aber so sehr DF generell eine Menge Ahnung hat, und professional zu arbeiten scheint, deren Berichterstattung zu DLSS schien mir ein bisschen schräg. Bei DLSS 2.0 wollten sie einem glatt verkaufen, es wäre besser als nativ.

Und während sie bei FSR korrekt beschreien, wie TAAU eine überlegene Lösung ist, scheint es seltsam, dass davon bei DLSS1.0 noch keine Rede war.

AMD hat jedenfalls seine Versprechungen nicht einhalten können. So eine Technologie ist einfach ziemlich nutzlos, wenn die Bildqualität nicht stimmt und somit hat NVidia momentan einfach die besseren Argumente. DLSS 2.0 kann ein echter Gamechanger sein.

Ich konnte z.B. Cyberpunk in Raytracing Ultra auf ner 2060 Super spielbar zum laufen bekommen durch DLSS "Performance" in WQHD. Und das Spiel sieht trotzdem nicht matschig oder pixelig aus... Ohne DLSS hätte ich hier massiv Details reduzieren müssen, damit es überhaupt anständig läuft.

Das kann ich nicht bestätigen. Habe Cyberpunk wie gesagt in WQHD mit DLSS im Performance-Mode (also nativ 720p) gespielt und war fasziniert wie gut es damit aussah. Mal abgesehen davon, dass der Leistungsunterschied gegenüber nativ mit den selben EInstellungen unfassbar hoch war (nativ ist es ne Diashow auf meinem System) kann man natürlich schon hier und da sehen, dass etwas Bildinformation fehlt. Ich würde sagen, dass es ein wenig den Charakter eines gestreamten Signals hat, aber trotzdem um Welten besser ist als nativ 720p aussieht. Ist auch von Szene zu Szene unterschiedlich, manchmal sieht es wirklich aus wie nativ mit guter Kantenglättung, manchmal merkt man schon ein wenig, dass es skaliert ist. Das Verhältnis vom Verlust an Bildqualität zu gewonnener Performance ist jedenfalls sehr gut.

Zuletzt geändert von OchsvormBerg am 24.06.2021 14:45, insgesamt 1-mal geändert.

Re: AMD FidelityFX Super Resolution (FSR): Die Upscaling-Methode ist in den ersten Spielen verfügbar

Ich spiel es auch in WQHD und mir gefällt halt einfach dieses Krieseln auf der Straße nicht. An sich sieht es ja dennoch Top aus und läuft mit DLSS auch mit ca. 60FPS, aber das Krieseln. Hast du das echt nicht? Ist auch irgendwie nur auf der Straße...Triadfish hat geschrieben: ↑24.06.2021 14:33 Das kann ich nicht bestätigen. Habe Cyberpunk wie gesagt in WQHD mit DLSS im Performance-Mode (also nativ 720p) gespielt und war fasziniert wie gut es damit aussah. Mal abgesehen davon, dass der Leistungsunterschied gegenüber nativ mit den selben EInstellungen unfassbar hoch war (nativ ist es ne Diashow auf meinem System) kann man natürlich schon hier und da sehen, dass etwas Bildinformation fehlt. Ich würde sagen, dass es ein wenig den Charakter eines gestreamten Signals hat, aber trotzdem um Welten besser ist als nativ 720p aussieht. Ist auch von Szene zu Szene unterschiedlich, manchmal sieht es wirklich aus wie nativ mit guter Kantenglättung, manchmal merkt man schon ein wenig, dass es skaliert ist. Das Verhältnis vom Verlust an Bildqualität zu gewonnener Performance ist jedenfalls sehr gut.

-

OchsvormBerg

- Beiträge: 1379

- Registriert: 12.03.2008 20:17

- Persönliche Nachricht:

Re: AMD FidelityFX Super Resolution (FSR): Die Upscaling-Methode ist in den ersten Spielen verfügbar

Ist mir zumindest nicht bewusst aufgefallen. Wenn man genau hinsieht, bemerkt man natürlich schon hier und da, dass gegenüber nativ etwas Bildinformation fehlt, aber ein störendes Krieseln hatte ich nicht.

Re: AMD FidelityFX Super Resolution (FSR): Die Upscaling-Methode ist in den ersten Spielen verfügbar

So pauschal stimmt das zwar nicht, aber DLSS 2.0 kann - was den Detailgrad angeht - tatsächlich besser sein als nativ. Und warum das so ist, ist auch einfach erklärt: die hochaufgelösten Vorlagen mit denen die KI angelernt wird, enthalten Details, die in der niedrigeren Render-Auflösung oder in der etwas höheren Output-Auflösung sowie der nativen Auflösung einfach gegebenenfalls nicht enthalten sind und DLSS ist somit tatsächlich in der Lage, Bilddetails darzustellen, die du nativ schlicht nicht sehen würdest (jedenfalls nicht, wenn du nicht nicht von einer wesentlich höheren Auflösung downscalest). Natürlich kann man nicht sagen, dass das gesamte Bild besser ist als nativ - hier wird ja immernoch von einer niedrigeren Auflösung hochgerechnet und natürlich hängt die Möglichkeit solcher zusätzlichen Details eben auch von dem Quellmaterial ab - aber ja, je nach Kontext hat er mit der Aussage zumindest nicht wirklich gelogen.

Edit: ups, Leon-x war ein paar Stunden schneller. Das passiert, wenn man Tabs aufmacht und dann antwortet, ohne vorher neuzuladen.

Zuletzt geändert von NewRaven am 24.06.2021 17:20, insgesamt 2-mal geändert.

Hier könnte Ihre Werbung stehen...

Re: AMD FidelityFX Super Resolution (FSR): Die Upscaling-Methode ist in den ersten Spielen verfügbar

Die Wimpern mögen auf den ersten Blick sauberer aussehen, aber hauptsächlich werden die hauptsächlich dunkler und schärfer gemacht, die Pixelierung wurde verwaschen, weil der Algorythmus das halt so interpretiert. Wenn du auf die Augenbrauen schaust, wirst du auch sehen, wie dort einige Linien verlängert und verbunden werden, die eigentlich gar nicht da sind.

Bei DLSS2 sehen die Details rauer, schärfer, konstrastreicher aus.

Das mag man bevorzugen, aber ist halt eine Verfälschung des Ausgangsmaterials.

Zuletzt geändert von Temeter am 25.06.2021 00:47, insgesamt 4-mal geändert.

Re: AMD FidelityFX Super Resolution (FSR): Die Upscaling-Methode ist in den ersten Spielen verfügbar

Mal ganz ehrlich: Diese Behauptungen sind dermaßen absurd, dass es mich wundert, ob ihr auch nur die geringste Ahnung davon hat, wie Computer und Daten funktionieren. Oder Echtzeit-Rendern.NewRaven hat geschrieben: ↑24.06.2021 17:17die hochaufgelösten Vorlagen mit denen die KI angelernt wird, enthalten Details, die in der niedrigeren Render-Auflösung oder in der etwas höheren Output-Auflösung sowie der nativen Auflösung einfach gegebenenfalls nicht enthalten sind und DLSS ist somit tatsächlich in der Lage, Bilddetails darzustellen, die du nativ schlicht nicht sehen würdest

Aber da ihr eigentlich die Grundlagen kennen solltet, kann ich nur darauf schließen, dass ihr völlig aufs Marketing reingefallen seid.

Denn nein, nichts von den Daten, mit denen die DLSS-"KI" gefüttert wurde, landen bei euch keine auf dem PC. Und selbst wenn die 20 terrabyte an Photos und Videos mitliefern würden, würde es deine Optik im Spiel erstmal nicht verbessern können, weil Echtzeitrendern so eben nicht funktioniert. Aber hey, das sind halt keine Daten, sondern höchstens Konfigurationsdateien.

Die KI ist kein Schoßhündchen mit Erinnerungsvermögen; solange diese Daten nicht gespeichert werden, sind sie nicht da. Das ganze nutzt vermutlich ein neurales Netzwerk um die richtige DLSS-Konfiguration zu finden oder so, aber es KI zu nennen beeindruckt die Leute halt mehr.

Solange ihr nicht gerade Computer-Esoteriker seid, sollte es also offensichtlich sein, dass verlorene Daten nicht magisch wiederhergestellt werden. Da macht es auch keine Unterschied, womit man die KI trainiert hat.

Ihr mögt den DLSS-Look vielleicht bevorzugen, aber das ist nicht das original.

Zuletzt geändert von Temeter am 25.06.2021 00:55, insgesamt 6-mal geändert.

Re: AMD FidelityFX Super Resolution (FSR): Die Upscaling-Methode ist in den ersten Spielen verfügbar

Sieht eher dass du immer noch keine praxisnahe Erfahrung hast. Ich habe nie davon geschrieben dass gesamten Spieldaten bei einem landen. Denn es sind nur grundlegende Daten verschiedener Quellen die antrainiert werden.Temeter hat geschrieben: ↑25.06.2021 00:39

Mal ganz ehrlich: Diese Behauptungen sind dermaßen absurd, dass es mich wundert, ob ihr auch nur die geringste Ahnung davon hat, wie Computer und Daten funktionieren. Oder Echtzeit-Rendern.

Aber da ihr eigentlich die Grundlagen kennen solltet, kann ich nur darauf schließen, dass ihr völlig aufs Marketing reingefallen seid.

Denn nein, nichts von den Daten, mit denen die DLSS-"KI" gefüttert wurde, landen bei euch keine auf dem PC. Und selbst wenn die 20 terrabyte an Photos und Videos mitliefern würden, würde es deine Optik im Spiel erstmal nicht verbessern können, weil Echtzeitrendern so eben nicht funktioniert. Aber hey, das sind halt keine Daten, sondern höchstens Konfigurationsdateien.

Erklär mal wie DLSS bei Gitter oder Stromleitung die nativen 4k Darstellung Unterbrechungen hat dann richtig rekonstruiert? Details die Manz.B. erst sieht wenn man mindestens 8k fährt. Höchstens Downsampling von 8k auf 4k vornimmt.

Wie kommt Redakteur wie Raff bei PCGH zu solchen Aussagen der die Dinge testet:

Quelle:"Ideal sähen Spiele aus, wenn man sie nicht am Ende in eine Pixelmatrix pressen müsste. Daher kommt ja das Aliasing. DLSS "erfindet" nichts dazu, es weiß. Es weiß, wie der Content mit 64-fachem Supersampling aussieht, und rekonstruiert alles, was durch die wesentlich geringere Bildschirmauflösung im Raster absäuft. Bessere Bilder zu erzeugen als "nativ" (was auch nur eine geringe Auflösung ist) ist kein Erfinden, das ist der Versuch, die Referenz nachzubilden (Ground Truth). Daher werden sich DLSS 2.x und DSR-Bilder (supersampled) auch so ähnlich, beide können mehr Details abbilden als bei nativer Darstellung, u. a. zu sehen in unserer Outriders-Abhandlung."

https://extreme.pcgameshardware.de/thre ... r-cry-6-re

Zudem gibt es von User gerX7a gute Erläuterung wie DLSS in neuesten Version funktioniert. Pack es mal in Spoiler wegen der Länge:

Spoiler

Show

DLSS 2.x rekonstruiert einen konkreten Frame auf Basis mehrerer Frames und innerhalb diesen können sich Bildbestandteile unterschiedlich durchs Bild bewegen. Ohne Bewegungsvektoren könnte das NN nur die Farbpixel betrachten und müsste raten ob der rosarote Pixel, der sich von Frame zu Frame von rechts unten nach links oben bewegt immer das gleiche Objekt darstellt und dass man das entsprechend bei der Rekonstruktion des aktuellen Frames annehmen kann. Mit den Bewegungsvektoren weiß DLSS welche Pixel zusammengehören und kann präziser abschätzen.

Das kommt z. B. auch zum Tragen wenn sich ein größerer "Pixelhaufen" der zu einem Objekt (oder auch nur zu einem Teil von diesem) gehört gemeinsam durchs Bild bewegt. Die Zusammengehörigkeit erkennt DLSS erst zuverlässig durch Bewegungsvektoren. Zudem, da hier mehrere Frames in die Rekonstruktion einfließen und wir hier von Rasterisierung sprechen, ist es z. B. möglich, dass dieser "Pixelhaufen" in vorausgehend Frames stellenweise mehr Details offenbarte, als es bspw. im nativen Rendering des aktuellen Frames der Fall ist. DLSS kann diese Informationen mitverwerten und in die aktuelle Rekonstruktion einfließen lassen, auch wenn der aktuelle Frame das eine oder andere konkrete Detail gar nicht hergib und das führt zu solchen Aussagen wie einem stellenweise "überaus gelungenem Raten" bzw. zu "rekonstruiert Details die eigentlich gar nicht da sind", denn stellenweise waren die durchaus mal da, wenn auch nur kurzzeitig, denn bereits kleine Objektverschiebungen im recht groben Pixelraster können schnell zu einem andersartigen Rendering des Objektes führen.

Im Trainigsprozess wird das zugrundeliegende neuronale Netz im Wesentlichen lernen diese lokal gemeinsamen Pixel eines Objektes zuverlässig über mehrere Frames zu erkennen (u. a. mithilfe der Bewegungsvektoren) und Details und Interpolationen zu erkennen und diese dann in den neu zu rekonstruierenden Frame einzuarbeiten. Entsprechend sollte man hier nicht etwa meinen, dass das Netz "lernt" Autos, Menschen, Hunde, Häuser und diverse schräge Charaktere zu erkennen und dass es sich merkt wie diese aussehen bzw. auszusehen haben, sodass es sie rekonstruieren kann. Das dürfte ein Trugschluss sein, denn nVidia trainiert hier ein universell nutzbares Netz, das auf alle möglichen Titel angewendet werden kann, d. h. es lernt nichts Konkretes. Dies kann es auch grundsätzlich nicht, da Neuveröffentlichungen das nächste schräge SciFi-Autodesign präsentieren werden oder den nächsten skurrilen Bösewicht, der nicht nur über ein paar abgedrehte Narben und kybernetische Erweiterungen verfügt, sondern auch noch eine Mischung aus einem Alien und einem Gorilla ist. So was kann das NN natürlicherweise nicht vorab antizipieren (logischerweise, denn das ist letzten Endes schlicht kodifizierte Statistik und Wahrscheinlichkeit und hat eher wenig mit dem "I" in KI zu tun).

Ein weiterer wichtiger Teilaspekt ist die temporale Stabilität einzelner Bildbereiche sicherzustellen und bspw. hässlich-flackernde Moire-Muster zu vermeiden, was bei filigranen, sich leicht bewegenden Objekte, die auf ein grobes Pixelraster abgebildet werden, leicht zustande kommen kann.

"... lässt sich meiner Meinung nach, ohne Vergleiche der Resultate, nicht sagen welche Technik die Bessere ist."

Selbstredend nicht und das dürfte den meisten auch bewusst sein, auch wenn es hier regelmäßge und im speziellen besonders auffallende Ausnahmen gibt, die nicht müde werden nun AMD die GPU-Weltherrschaft zuzuschreiben.

Schlussendlich scheint AMDs Ansatz einfacher gestrickt zu sein, was auch nicht verwundert, denn primär ist die Technik dafür da die Konsolen zu pimpen und 4K mit hohen Fps zu ermöglichen und hier stehen gerade mal 36 schnellere oder 52 langsamere CUs zur Verfügung. Das in Verbindung mit dem bisher präsentierten und den rudimentären Informationen zur Implementation lässt einfach die Wahrscheinlichkeit höher erscheinen, dass FSR DLSS nicht ganz das Wasser reichen können wird, aber letzten Endes sollte man hier einfach mal abwarten bis konkrete Implementationen zum freien Testen vorliegen, idealerweise in einem Fall mit einem Titel der beide Techniken implementiert, damit man einen direkten 1:1-Vergleich vornehmen kann. Wenn man Pech hat wird insbesondere dies jedoch noch ein Weilchen dauern.

"Auch große Gruppen können irren, bzw. nur weil 2 Unternehmen es mit Vektoren machen, muss es nicht das Beste sein."

Ersteres ist zweifellos richtig, bedeutet im Umkehrschluss aber ebensowenig, dass diese Gruppen falsch liegen, wenn es der persönlichen Ansicht zuwiderläuft.

Und ebenso bedeutet diese Aussage auch nicht, dass wenn ein Unternehmen es ohne versucht, dieses den besseren oder sinnvolleren Ansatz gewählt haben muss. Im Wesentlichen kann man AMD hier unterstellen, dass sie einerseits keine Funktionseinheiten für die beschleunigte Prozessierung von NNs besitzen (und das daher berücksichtigen müssen) und weiterhin, dass hier explizit die Unterstützung der kleinen Konsolen-GPUs im Fokus stand, was ihren Handlungsspielraum schon einmal per se einschränkt. *)

Schlussendlich einfach mal abwarten. Am Ende ist ja auch die Frage welche persönliche Erwartungshaltung man an den Einsatz einer solchen Technik stellt. Die einen wollen primär hohe Fps und nehmen qualitative Kompromisse durchaus in Kauf, andere wollen das nicht, wieder anderen reichen vielleicht nur kleine Fps-Zugewinne, jedoch wollen die dafür eine maximale visuelle Qualität. Hier kann man durchaus entlang verschiedener Achsen messen und dementsprechend wird es vermutlich auch keine einzelne Antwort bzgl. der Bewertung geben können.

Das kommt z. B. auch zum Tragen wenn sich ein größerer "Pixelhaufen" der zu einem Objekt (oder auch nur zu einem Teil von diesem) gehört gemeinsam durchs Bild bewegt. Die Zusammengehörigkeit erkennt DLSS erst zuverlässig durch Bewegungsvektoren. Zudem, da hier mehrere Frames in die Rekonstruktion einfließen und wir hier von Rasterisierung sprechen, ist es z. B. möglich, dass dieser "Pixelhaufen" in vorausgehend Frames stellenweise mehr Details offenbarte, als es bspw. im nativen Rendering des aktuellen Frames der Fall ist. DLSS kann diese Informationen mitverwerten und in die aktuelle Rekonstruktion einfließen lassen, auch wenn der aktuelle Frame das eine oder andere konkrete Detail gar nicht hergib und das führt zu solchen Aussagen wie einem stellenweise "überaus gelungenem Raten" bzw. zu "rekonstruiert Details die eigentlich gar nicht da sind", denn stellenweise waren die durchaus mal da, wenn auch nur kurzzeitig, denn bereits kleine Objektverschiebungen im recht groben Pixelraster können schnell zu einem andersartigen Rendering des Objektes führen.

Im Trainigsprozess wird das zugrundeliegende neuronale Netz im Wesentlichen lernen diese lokal gemeinsamen Pixel eines Objektes zuverlässig über mehrere Frames zu erkennen (u. a. mithilfe der Bewegungsvektoren) und Details und Interpolationen zu erkennen und diese dann in den neu zu rekonstruierenden Frame einzuarbeiten. Entsprechend sollte man hier nicht etwa meinen, dass das Netz "lernt" Autos, Menschen, Hunde, Häuser und diverse schräge Charaktere zu erkennen und dass es sich merkt wie diese aussehen bzw. auszusehen haben, sodass es sie rekonstruieren kann. Das dürfte ein Trugschluss sein, denn nVidia trainiert hier ein universell nutzbares Netz, das auf alle möglichen Titel angewendet werden kann, d. h. es lernt nichts Konkretes. Dies kann es auch grundsätzlich nicht, da Neuveröffentlichungen das nächste schräge SciFi-Autodesign präsentieren werden oder den nächsten skurrilen Bösewicht, der nicht nur über ein paar abgedrehte Narben und kybernetische Erweiterungen verfügt, sondern auch noch eine Mischung aus einem Alien und einem Gorilla ist. So was kann das NN natürlicherweise nicht vorab antizipieren (logischerweise, denn das ist letzten Endes schlicht kodifizierte Statistik und Wahrscheinlichkeit und hat eher wenig mit dem "I" in KI zu tun).

Ein weiterer wichtiger Teilaspekt ist die temporale Stabilität einzelner Bildbereiche sicherzustellen und bspw. hässlich-flackernde Moire-Muster zu vermeiden, was bei filigranen, sich leicht bewegenden Objekte, die auf ein grobes Pixelraster abgebildet werden, leicht zustande kommen kann.

"... lässt sich meiner Meinung nach, ohne Vergleiche der Resultate, nicht sagen welche Technik die Bessere ist."

Selbstredend nicht und das dürfte den meisten auch bewusst sein, auch wenn es hier regelmäßge und im speziellen besonders auffallende Ausnahmen gibt, die nicht müde werden nun AMD die GPU-Weltherrschaft zuzuschreiben.

Schlussendlich scheint AMDs Ansatz einfacher gestrickt zu sein, was auch nicht verwundert, denn primär ist die Technik dafür da die Konsolen zu pimpen und 4K mit hohen Fps zu ermöglichen und hier stehen gerade mal 36 schnellere oder 52 langsamere CUs zur Verfügung. Das in Verbindung mit dem bisher präsentierten und den rudimentären Informationen zur Implementation lässt einfach die Wahrscheinlichkeit höher erscheinen, dass FSR DLSS nicht ganz das Wasser reichen können wird, aber letzten Endes sollte man hier einfach mal abwarten bis konkrete Implementationen zum freien Testen vorliegen, idealerweise in einem Fall mit einem Titel der beide Techniken implementiert, damit man einen direkten 1:1-Vergleich vornehmen kann. Wenn man Pech hat wird insbesondere dies jedoch noch ein Weilchen dauern.

"Auch große Gruppen können irren, bzw. nur weil 2 Unternehmen es mit Vektoren machen, muss es nicht das Beste sein."

Ersteres ist zweifellos richtig, bedeutet im Umkehrschluss aber ebensowenig, dass diese Gruppen falsch liegen, wenn es der persönlichen Ansicht zuwiderläuft.

Und ebenso bedeutet diese Aussage auch nicht, dass wenn ein Unternehmen es ohne versucht, dieses den besseren oder sinnvolleren Ansatz gewählt haben muss. Im Wesentlichen kann man AMD hier unterstellen, dass sie einerseits keine Funktionseinheiten für die beschleunigte Prozessierung von NNs besitzen (und das daher berücksichtigen müssen) und weiterhin, dass hier explizit die Unterstützung der kleinen Konsolen-GPUs im Fokus stand, was ihren Handlungsspielraum schon einmal per se einschränkt. *)

Schlussendlich einfach mal abwarten. Am Ende ist ja auch die Frage welche persönliche Erwartungshaltung man an den Einsatz einer solchen Technik stellt. Die einen wollen primär hohe Fps und nehmen qualitative Kompromisse durchaus in Kauf, andere wollen das nicht, wieder anderen reichen vielleicht nur kleine Fps-Zugewinne, jedoch wollen die dafür eine maximale visuelle Qualität. Hier kann man durchaus entlang verschiedener Achsen messen und dementsprechend wird es vermutlich auch keine einzelne Antwort bzgl. der Bewertung geben können.

Die haben Alle keine Ahnung und fallen sicherlich wie wir nur auf Marketing rein.^^

Keiner spricht hier von Wunder aber es ist eben doch möglich Teilbereiche zu rekonstruieren bei kleineren Renderauflösungen die eigentlich erst in weit höher aufgelösten Material zu finden sind.

Mal davon ab dass Dinge wie "Original" bei Videospielgrafik eh etwas mit Vorsicht zu genießen ist. Original am nächsten kommt eher 8k bzw besser 16k Material was ohne Kantenglättungsmethoden auskommt und Details weniger durchs Pixelraster fallen als bei 4k und darunter. Sicherlich nicht 1440p Ausgabe auf WQHD Display oder 2160p auf UHD die wegen Flimmern immer noch AA-Methode benötigen was wiederum das Bild verändert und darin eingreift.

Wie schon mal gesagt ist DLSS auch Art Kantglättung und nicht nur Upscaler.

Zuletzt geändert von Leon-x am 25.06.2021 02:30, insgesamt 2-mal geändert.

-PC

-Playstation 5

-Nintendo Switch

-Xbox Series X

-Playstation 5

-Nintendo Switch

-Xbox Series X

Re: AMD FidelityFX Super Resolution (FSR): Die Upscaling-Methode ist in den ersten Spielen verfügbar

Also erstmal spezifisch ging es mir um die Idee, dass die "KI", bzw das neuronale Netz, irgendwelche Informationen gelernt hat und damit zusätzliche Informationen mitbringt. Direkt auf eure Kommentare bezogen.Leon-x hat geschrieben: ↑25.06.2021 02:12Sieht eher dass du immer noch keine praxisnahe Erfahrung hast. Ich habe nie davon geschrieben dass gesamten Spieldaten bei einem landen. Denn es sind nur grundlegende Daten verschiedener Quellen die antrainiert werden.

Erklär mal wie DLSS bei Gitter oder Stromleitung die nativen 4k Darstellung Unterbrechungen hat dann richtig rekonstruiert? Details die Manz.B. erst sieht wenn man mindestens 8k fährt. Höchstens Downsampling von 8k auf 4k vornimmt.

Und nein, das ist definitiv falsch. Auf deiner Maschine hast du nichtmal eine KI am laufen, sondern einen Haufen Code, der eben beinflussst von den Daten ist, die das neuronale Netz produziert hat.

Der "gerX7a" scheint tatsächlich zu verstehen, wovon er da spricht. Aber was er da sagt, hat eben nichts damit zu tun, dass die KI mit hochaufgelösten Screenshots gefüttert wurde und sich irgendetwas gemerkt hat.Quelle:"Ideal sähen Spiele aus, wenn man sie nicht am Ende in eine Pixelmatrix pressen müsste. Daher kommt ja das Aliasing. DLSS "erfindet" nichts dazu, es weiß. Es weiß, wie der Content mit 64-fachem Supersampling aussieht, und rekonstruiert alles, was durch die wesentlich geringere Bildschirmauflösung im Raster absäuft. Bessere Bilder zu erzeugen als "nativ" (was auch nur eine geringe Auflösung ist) ist kein Erfinden, das ist der Versuch, die Referenz nachzubilden (Ground Truth). Daher werden sich DLSS 2.x und DSR-Bilder (supersampled) auch so ähnlich, beide können mehr Details abbilden als bei nativer Darstellung, u. a. zu sehen in unserer Outriders-Abhandlung."

https://extreme.pcgameshardware.de/thre ... r-cry-6-re

Zudem gibt es von User gerX7a gute Erläuterung wie DLSS in neuesten Version funktioniert. Pack es mal in Spoiler wegen der Länge:

Selber Thread in der Quelle verlinkt.SpoilerShowDLSS 2.x rekonstruiert einen konkreten Frame auf Basis mehrerer Frames und innerhalb diesen können sich Bildbestandteile unterschiedlich durchs Bild bewegen. Ohne Bewegungsvektoren könnte das NN nur die Farbpixel betrachten und müsste raten ob der rosarote Pixel, der sich von Frame zu Frame von rechts unten nach links oben bewegt immer das gleiche Objekt darstellt und dass man das entsprechend bei der Rekonstruktion des aktuellen Frames annehmen kann. Mit den Bewegungsvektoren weiß DLSS welche Pixel zusammengehören und kann präziser abschätzen.

Das kommt z. B. auch zum Tragen wenn sich ein größerer "Pixelhaufen" der zu einem Objekt (oder auch nur zu einem Teil von diesem) gehört gemeinsam durchs Bild bewegt. Die Zusammengehörigkeit erkennt DLSS erst zuverlässig durch Bewegungsvektoren. Zudem, da hier mehrere Frames in die Rekonstruktion einfließen und wir hier von Rasterisierung sprechen, ist es z. B. möglich, dass dieser "Pixelhaufen" in vorausgehend Frames stellenweise mehr Details offenbarte, als es bspw. im nativen Rendering des aktuellen Frames der Fall ist. DLSS kann diese Informationen mitverwerten und in die aktuelle Rekonstruktion einfließen lassen, auch wenn der aktuelle Frame das eine oder andere konkrete Detail gar nicht hergib und das führt zu solchen Aussagen wie einem stellenweise "überaus gelungenem Raten" bzw. zu "rekonstruiert Details die eigentlich gar nicht da sind", denn stellenweise waren die durchaus mal da, wenn auch nur kurzzeitig, denn bereits kleine Objektverschiebungen im recht groben Pixelraster können schnell zu einem andersartigen Rendering des Objektes führen.

Im Trainigsprozess wird das zugrundeliegende neuronale Netz im Wesentlichen lernen diese lokal gemeinsamen Pixel eines Objektes zuverlässig über mehrere Frames zu erkennen (u. a. mithilfe der Bewegungsvektoren) und Details und Interpolationen zu erkennen und diese dann in den neu zu rekonstruierenden Frame einzuarbeiten. Entsprechend sollte man hier nicht etwa meinen, dass das Netz "lernt" Autos, Menschen, Hunde, Häuser und diverse schräge Charaktere zu erkennen und dass es sich merkt wie diese aussehen bzw. auszusehen haben, sodass es sie rekonstruieren kann. Das dürfte ein Trugschluss sein, denn nVidia trainiert hier ein universell nutzbares Netz, das auf alle möglichen Titel angewendet werden kann, d. h. es lernt nichts Konkretes. Dies kann es auch grundsätzlich nicht, da Neuveröffentlichungen das nächste schräge SciFi-Autodesign präsentieren werden oder den nächsten skurrilen Bösewicht, der nicht nur über ein paar abgedrehte Narben und kybernetische Erweiterungen verfügt, sondern auch noch eine Mischung aus einem Alien und einem Gorilla ist. So was kann das NN natürlicherweise nicht vorab antizipieren (logischerweise, denn das ist letzten Endes schlicht kodifizierte Statistik und Wahrscheinlichkeit und hat eher wenig mit dem "I" in KI zu tun).

Ein weiterer wichtiger Teilaspekt ist die temporale Stabilität einzelner Bildbereiche sicherzustellen und bspw. hässlich-flackernde Moire-Muster zu vermeiden, was bei filigranen, sich leicht bewegenden Objekte, die auf ein grobes Pixelraster abgebildet werden, leicht zustande kommen kann.

"... lässt sich meiner Meinung nach, ohne Vergleiche der Resultate, nicht sagen welche Technik die Bessere ist."

Selbstredend nicht und das dürfte den meisten auch bewusst sein, auch wenn es hier regelmäßge und im speziellen besonders auffallende Ausnahmen gibt, die nicht müde werden nun AMD die GPU-Weltherrschaft zuzuschreiben.

Schlussendlich scheint AMDs Ansatz einfacher gestrickt zu sein, was auch nicht verwundert, denn primär ist die Technik dafür da die Konsolen zu pimpen und 4K mit hohen Fps zu ermöglichen und hier stehen gerade mal 36 schnellere oder 52 langsamere CUs zur Verfügung. Das in Verbindung mit dem bisher präsentierten und den rudimentären Informationen zur Implementation lässt einfach die Wahrscheinlichkeit höher erscheinen, dass FSR DLSS nicht ganz das Wasser reichen können wird, aber letzten Endes sollte man hier einfach mal abwarten bis konkrete Implementationen zum freien Testen vorliegen, idealerweise in einem Fall mit einem Titel der beide Techniken implementiert, damit man einen direkten 1:1-Vergleich vornehmen kann. Wenn man Pech hat wird insbesondere dies jedoch noch ein Weilchen dauern.

"Auch große Gruppen können irren, bzw. nur weil 2 Unternehmen es mit Vektoren machen, muss es nicht das Beste sein."

Ersteres ist zweifellos richtig, bedeutet im Umkehrschluss aber ebensowenig, dass diese Gruppen falsch liegen, wenn es der persönlichen Ansicht zuwiderläuft.

Und ebenso bedeutet diese Aussage auch nicht, dass wenn ein Unternehmen es ohne versucht, dieses den besseren oder sinnvolleren Ansatz gewählt haben muss. Im Wesentlichen kann man AMD hier unterstellen, dass sie einerseits keine Funktionseinheiten für die beschleunigte Prozessierung von NNs besitzen (und das daher berücksichtigen müssen) und weiterhin, dass hier explizit die Unterstützung der kleinen Konsolen-GPUs im Fokus stand, was ihren Handlungsspielraum schon einmal per se einschränkt. *)

Schlussendlich einfach mal abwarten. Am Ende ist ja auch die Frage welche persönliche Erwartungshaltung man an den Einsatz einer solchen Technik stellt. Die einen wollen primär hohe Fps und nehmen qualitative Kompromisse durchaus in Kauf, andere wollen das nicht, wieder anderen reichen vielleicht nur kleine Fps-Zugewinne, jedoch wollen die dafür eine maximale visuelle Qualität. Hier kann man durchaus entlang verschiedener Achsen messen und dementsprechend wird es vermutlich auch keine einzelne Antwort bzgl. der Bewertung geben können.

Die haben Alle keine Ahnung und fallen sicherlich wie wir nur auf Marketing rein.^^

Keiner spricht hier von Wunder aber es ist eben doch möglich Teilbereiche zu rekonstruieren bei kleineren Renderauflösungen die eigentlich erst in weit höher aufgelösten Material zu finden sind.

Mal davon ab dass Dinge wie "Original" bei Videospielgrafik eh etwas mit Vorsicht zu genießen ist. Original am nächsten kommt eher 8k bzw besser 16k Material was ohne Kantenglättungsmethoden auskommt und Details weniger durchs Pixelraster fallen als bei 4k und darunter. Sicherlich nicht 1440p Ausgabe auf WQHD Display oder 2160p auf UHD die wegen Flimmern immer noch AA-Methode benötigen was wiederum das Bild verändert und darin eingreift.

Wie schon mal gesagt ist DLSS auch Art Kantglättung und nicht nur Upscaler.

Er beschreibt im Grunde einfach temporales Upscaling (ähnlich TAAU), und wie DLSS es einsetzt. Und ja, wenn du das machst, kannst du Bildinformationen über mehrere Frames hinweg sammeln, auch wenn das oft etwas unzuverlässig ist und du Nebeneffekte wie Ghosting praktisch zwangsweise mit dabei sind.

Wie effektiv das ist, darüber kann man streiten. Aber das sind keine Informationen aus dem Nirgendwo, kein rumraten oder spekulieren von irgendeiner KI.

Und gerade mit Ghostnig/Schlieren finde ich es doch sehr seltsam, wenn das Überlegen zu Nativ sein soll. Die Screenshots wirken auf mich auch eher, als ob DLSS 2.0 in der Tat nicht super präzise ist?

Zuletzt geändert von Temeter am 25.06.2021 03:39, insgesamt 2-mal geändert.

-

AS Sentinel

- Beiträge: 315

- Registriert: 05.06.2011 15:23

- Persönliche Nachricht:

Re: AMD FidelityFX Super Resolution (FSR): Die Upscaling-Methode ist in den ersten Spielen verfügbar

muss mal dumm fragen. schließt "AMD Radeon 5000/5000M Serie" auch die 5700xt ein?

Re: AMD FidelityFX Super Resolution (FSR): Die Upscaling-Methode ist in den ersten Spielen verfügbar

Ich habe nirgends geschieben dass ein KI-Programm am Rechner und im Treiber sitzt. Es ist Programm was bei Nvidia in ihrer Serverfarm trainiert wird. Selber landen nur einige Infos im Treiber wie DLSS dann von Spiel/Software ausgeführt wird.Temeter hat geschrieben: ↑25.06.2021 03:36

Wie effektiv das ist, darüber kann man streiten. Aber das sind keine Informationen aus dem Nirgendwo, kein rumraten oder spekulieren von irgendeiner KI.

Und gerade mit Ghostnig/Schlieren finde ich es doch sehr seltsam, wenn das Überlegen zu Nativ sein soll. Die Screenshots wirken auf mich auch eher, als ob DLSS 2.0 in der Tat nicht super präzise ist?

Habe auch gesagt dass es Teilbereiche sind. Dass es zum Nachteil Ghosting gibt habe ich auch erwähnt weil es eben temporal mit Bewegungsvektoren arbeitet. Nicht geschrieben dass das komplette Bild überlegen ist.

Nur wird der Problem mit Ghosting durch DLSS 2.2 schon angegangen. Death Stranding hatten ja diese kleinen fliegenden Würmchen so Nachzieheffekt mit DLSS 2.2. Wenn man jetzt DLSS 2.2 edititert (Siel muss keinen offizellen Support haben da man nur dll-Datei anpasst) dann sieht man hier zum Schluss im Video dass der einst negative Effekt so gut wie verschwunden ist:

Spoiler

Show

Nur kann es eben Dinge wie feinen Linien (Haare, Stromleistungen, Gitterstreben) korrekt rekonstruieren die selbst bei 2160p durch Pixelraster fallen oder durch AA-Lösung zu Fehldarstellungen kommen.

Vielleicht siehst du die Stromleistung korrekt wenn man AA deaktiviert aber ist dann ausgefranst oder flimmert sogar. Wenn DLSS jetzt die Leistung ohne Unterbrechnung glättet ist es für mich "Originaler" weil man eben eine komplette Stromleistung sieht. Die sonst erst auf 8k Screen korrekt ohne Upscaling dargestellt werden würde.

Sonst würde ja der 540p DLSS nicht z.B. Haarsträhne wie hier in Control mehr wiedergeben als 1080p Nativ:

Spoiler

Show

Letzten Endes ist alles ist irgendwo Kompromiss. Nur weil man 2160p als Renderauflösung einstellt heißt es nicht dass Entwickler Effekte nicht in kleineren Auflösungen berechnen lässt. Somit kann es da schon zu Problemen in der Struktur kommen.

Mit jeder eingesetzten AA-Methode verändern wir im Bild die pixelgenaue Darstellung an Kanten und Linien weil sie sonst zu grob oder zu flimmern beginnen. Da selbst 4k noch keine so hohe Pixeldichte hat um feine Sachen problemlos dazustellen.

Problem löst sich erst wenn wir dann weit höhere Auflösungen als 2160p fahren können. Sowas ist noch sehr weit entfernte Zukunft da nicht mal 4k der absolute Standard ist.

-PC

-Playstation 5

-Nintendo Switch

-Xbox Series X

-Playstation 5

-Nintendo Switch

-Xbox Series X

Re: AMD FidelityFX Super Resolution (FSR): Die Upscaling-Methode ist in den ersten Spielen verfügbar

Uhhh... was?! Natürlich kreiert die KI keine Details, dass ist auch überhaupt nicht ihr Job. Ihr Job ist es, anhand höher aufgelöster Vorlagen zu erkennen, wo Details aus höher aufgelösten Texturen, die ja vorliegen (beschränken wir uns erstmal der Einfachheit ruhig darauf) in runtergerechneten Texturauflösungen korrekt hinpassen, wenn diese Textur skaliert auf ein Mesh gelegt wird. Und mehr als diese Angaben braucht das "neuronale Netz" dann auch nicht generieren, dass muss da nichts "erfinden", dass muss auch nicht lokal laufen - das muss einfach nur definieren können, wo welche Details aus höher aufgelösten Texturen - Bildinformationen halt - auch bei den dann verwendeten niedriger aufgelösten Texturen noch noch sichtbar wären, wenn man eine Textur in dieser Auflösung über ein Model in der Spielwelt stülpt - was sie im Regelfall skaliert - den Rest macht die DLSS-Implementierung im Spiel selbst, sprich die Engine. Die Leistung von DLSS 2.x - und eben der KI dahinter, ist eben eher, dass es, um diese "Anweisungen" zu geben eben nicht mehr unzählige Vorlagen von einem konkreten Spiel für ein konkretes Spiel braucht, um zu wissen, wo sie welches Detail ergänzen kann und wo nicht, sondern das eben aus der Masse von Daten vorausberechnen kann.

Über welchen Part diskutieren wir jetzt eigentlich? Darüber, dass eine niedrigere Scaling-Textur in 720p weniger Details respektive Bildinformationen hat, als eine native Textur in 1440p. Darüber, dass eine 4k Textur sichtbare Details verliert, wenn man sie einfach 720p runterrechnet? Darüber, dass es möglich ist, diesem 720p Bild gezielt Details wieder hinzuzufügen, wenn man die 4k Vorlage kennt (oder KI-berechnet "erahnt") und das, mit diesen Details wieder hinzugefügt, ein Bild in Bezug auf diese rekonstruierten Dinge in eben diesen Details (und nur in denen) besser aussehen kann als ein 1080p-Bild, bei dem man diese Details eben nicht wieder hinzugefügt hat? Ich bin etwas... irritiert. Und nein, natürlich ist das nicht "super präzise" weil dieses "Anweisungssystem" eben immernoch auf berechneten Wahrscheinlichkeiten beruht - deshalb ja eben auch KI.

Zuletzt geändert von NewRaven am 25.06.2021 15:23, insgesamt 1-mal geändert.

Hier könnte Ihre Werbung stehen...

-

johndoe711686

- Beiträge: 15758

- Registriert: 23.12.2007 19:02

- Persönliche Nachricht:

Re: AMD FidelityFX Super Resolution (FSR): Die Upscaling-Methode ist in den ersten Spielen verfügbar

Das stimmt zwar, aber mal Hand aufs Herz, beim Spielen fällt dir sowas aus dem Bild doch null auf. Das wirkt auf einem direkten und vergößerten Vergleich nett, aber mehr nicht. Auf deinem anderen Bild sehe ich beim ersten hinschauen kaum einen Unterschied, geschweige denn, könnte ich sagen, was was ist. DAS ist der eigentliche Benefit, dass es nicht schlechter aussieht, dabei aber deutlich performanter läuft. Ob da jetzt Wimpern besser aussehen, pfft.

@NewRaven und so

Ich glaube er stört sich an "KI", weil es keine "echte" KI ist.

Zuletzt geändert von johndoe711686 am 25.06.2021 15:41, insgesamt 1-mal geändert.

Re: AMD FidelityFX Super Resolution (FSR): Die Upscaling-Methode ist in den ersten Spielen verfügbar

Das mit der DLL werd ich mal ausprobieren. Death Stranding hat nämlich arge Fehler in der Darstellung mit DLSS, aber ich hab zu wenig Erfahrung damit um das jetzt auf DLSS oder das Spiel selbst zu schieben.